مجله مطالب خواندنی

سبک زندگی، روانشناسی، سلامت،فناوری و ....مجله مطالب خواندنی

سبک زندگی، روانشناسی، سلامت،فناوری و ....خزنده وب چیست و نحوه کار با آن چگونه است؟

[ad_1]خزنده وب یا Web crawler به برنامه کامپیوتری میگویند که وب را بازدید کرده و اطلاعات آن را پردازش میکند. درباره خزنده وب بیشتر بدانید.

خزنده وب (WEB CRAWLER) چیست؟

خزنده وب که بیشتر ما آن را با عنوان Web crawler میشناسیم به برنامه کامپیوتری اطلاق میشود که World Wide Web (وب جهان گستر) را به صورت مرتب و سلسله مراتبی بازدید کرده و اطلاعات آن را مورد پردازش قرار میدهد. از Web crawler ها با عناوین دیگری مانند ants ،automatic indexers ،bots ،Web spiders و Web robots نیز یاد میشود.

کاربردهای خزنده وب

1. موتورهای جستجو

موتورهای جستجو و برخی از سایتها دارای خزندهها و یا روباتهایی هستند که برای گردآوری اطلاعات وب سایتها و نیز بروز نگه داشتن اطلاعات مورد استفاده قرار میگیرند. مهمترین کار بعد از گردآوری اطلاعات، ایندکس کردن آنها برای پردازش سریع هنگام جستجو است. این خزندهها معمولا در بازههای زمانی منظمی اطلاعات را بروز کرده و با نسخههای قبلی مقایسه میکنند.

2. مدیریت فنی وب سایت

مدیریت فنی وب سایت بخشی از کار این خزندههاست که شامل یافتن لینکهای شکسته(Broken Link) ، اعتبار سنجی (Validation) کدهای HTML، فایلهای CSS و … میباشد.

3. جمع آوری اطلاعات خاص

کاربرد دیگر خزندههای وب جمع آوری اطلاعات خاصی مانند آدرسهای ایمیل است. معمولا هدف از اینکار ارسال هرزنامه (spam) میباشد. برای جلوگیری از ثبت آدرس ایمیل توسط این خزندهها، میتوانید آدرس ایمیل خود را به صورت saeidREMOVEME AT جیمیل و یا موارد مشابه دیگر بنویسید.

نحوه کار خزنده وب

به صورت عمومی نحوه کار Web crawler ها به این صورت است که ابتدا لیستی از URL ها (آدرس های وب) که به عنوان seed شناخته میشوند را برای بازدید پردازش میکنند. هنگام پردازش این آدرسها، لیست لینکها و آدرسهای موجود در صفحات آنها را گردآوری کرده و به لیست ابتدایی اضافه میکنند. بقیه اطلاعات را نیز با توجه به نیاز و هدف خود ذخیره و پردازش مینمایند.

معماری خزنده وب

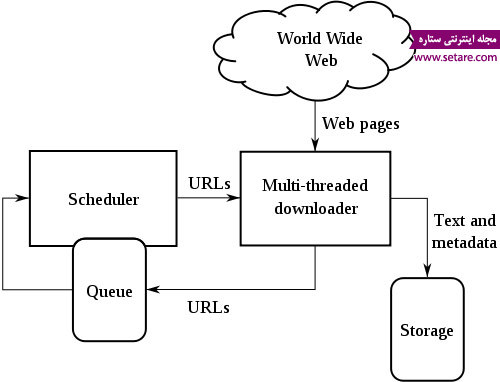

خزنده وب بخش اصلی و مرکزی هر موتور جستجویی را تشکیل میدهد. به همین جهت الگوریتم و معماری آنها به شدت مخفی نگه داشته میشود. با این وجود معماری سطح بالای (High-level architecture) آن به شکل زیر میباشد:

عادی کردن آدرس (URL NORMALIZATION)

منظور از عادی کردن آدرس، یکی کردن آدرسهایی میباشد که دارای خروجی یکسانی هستند. هدف از این کار جلوگیری از جمع آوری اطلاعات یکسان از چندین URL است. URL normalization با نام URL canonicalization نیز شناخته میشود که همان فرآیند تغییر آدرس برای استاندارد شدن میباشد.

مراحل فرایند عادی کردن آدرس

- تبدیل آدرس به حروف کوچک

HTTP://www.Example.com/ → http://www.example.com/

- افزودن / به آدرس در صورت نیاز

http://www.example.com → http://www.example.com/

- حذف آدرس ایندکس دایرکتوری

http://www.example.com/default.asp → http://www.example.com/

http://www.example.com/a/index.html → http://www.example.com/a/

- بزرگ کردن حروف encode شده یا همان حروف بعد از علامت ٪

http://www.example.com/a%c2%b1b → http://www.example.com/a%C2%B1b

http://www.example.com/bar.html#section1 → http://www.example.com/bar.html

- حذف و تبدیل آی پی به دامنه

http://208.77.188.166/ → http://www.example.com/

- اعمال محدودیت بر روی پروتکلها مانند تبدیل https به http

https://www.example.com/ → http://www.example.com/

- حذف پورت پیش فرض )پورت ۸۰ به صورت پیش فرض برای http میباشد).

http://www.example.com:80/bar.html → http://www.example.com/bar.html

- حذف / های تکراری

http://www.example.com:80/bar.html → http://www.example.com/bar.html

- حذف . ها (dot-segments)

http://www.example.com/../a/b/../c/./d.html → http://www.example.com/a/c/d.html

- حذف www از اول دامنه

http://www.example.com/ → http://example.com/

- مرتب کردن متغییرهای صفحه فعال

http://www.example.com/display?lang=en&article=fred

→ http://www.example.com/display?article=fred〈=en

- حذف متغییرهای اختیاری ازquery-string

http://www.example.com/display?id=123&fakefoo=fakebar

→ http://www.example.com/display?id=123

- حذف متغییرهای پیش فرض ازquery-string

http://www.example.com/display?id=&sort=ascending

→ http://www.example.com/display

- حذف علامت ? هنگامی که query-string خالی باشد

http://www.example.com/display? → http://www.example.com/display

- استانداردکردن encoding کاراکترها

http://www.example.com/display?category=foo/bar+baz

→ http://www.example.com/display?category=foo%2Fbar%20baz

شناسایی خزنده وب

خزندههای وب معمولا با استفاده از فیلد User-agent داده HTTP request خود را معرفی میکنند. شما با استفاده از لاگ وب سرور خود میتوانید لیست این Web crawler ها را مشاهده کنید. فیلدز User agent ممکن است شامل URL ای باشد که به سایت سازنده خزنده اشاره میکند.Spambot ها و سایر خزندههای مخرب معمولا فیلد User agent را به صورت غیر واقعی با اطلاعاتی مانند نام یک مرورگر پر میکنند.

فایل ROBOTS.TXT

این فایل برای دادن اطلاعات اولیه در زمینه وب سایت مورد پردازش به خزندههای وب استفاده میگردد. به عنوان مثال با این فایل میتوانید دسترسی خزندههای وب به بعضی زیر شاخهها را محدود کنید. دستورات زیر در فایل robots.txt از دسترسی خزندهها به دایرکتوری /tmp/ جلوگیری میکند:

(اگر درباره فایل Robot.txt نمیدانید، اینجا کلیک کنید).

User-agent: *

Disallow: /tmp/

نکته: فایل robots.txt یک استاندارد میباشد. به همین جهت خزنده وب (معمولا خزنده مخرب) میتواند آن را نادیده بگیرد.

معروف ترین خزندههای وب غیر آزاد

در زیر لیست معروفترین خزندههای وب را مشاهده میکنید:

- Yahoo! Slurp

- Msnbot

- FAST Crawler

- Googlebot

- Methabot

- arachnode.net

- PolyBot

- RBSE

- WebCrawler

- World Wide Web Worm

- WebFountain

- WebRACE

معروف ترین خزنده های متن باز

- Aspseek

- crawler4j

- DataparkSearch

- Ebot

- GNU Wget

- GRUB

- Heritrix

- ht://Dig

- HTTrack

- ICDL Crawler

- mnoGoSearch

- Nutch

- Open Search Server

- Pavuk

- YaCy

سورس خزنده وب به زبان جاوا

سایت sun در سال ۱۹۹۸ مقالهای آموزشی با عنوان "Writing a Web Crawler in the Java Programming Language” را ارائه داد. در آن مقاله ضمن توضیح دادن Web crawler سورس برنامه آن نیز در اختیار عموم قرار گرفت. البته این برنامه خیلی ساده و در مرحله ابتدایی میباشد. شما باید با توجه به نیازهای خود آن را تغییر داده و مورد استفاده قرار دهید.

گردآوری: مجله اینترنتی ستاره

[ad_2]

لینک منبع

بازنشر: مفیدستان

عبارات مرتبط با این موضوع

خزنده وب چیست و نحوه کار با آن چگونه است؟خزنده وب چیست؟ خزنده وب که بیشتر ما آن را با عنوان میشناسیم به برنامه خزنده های موتورهای جستجو چه هستند؟ چگونه کار می …چگونه کار می کنند؟ فعال است و اغلب یک وب سایت را عملکرد خزنده ها و آنچه آن ها درمان بیماری تاندونیت بازو به روش خانگیدرمانبیماریتاندونیت خزنده وب چیست و نحوه و نحوه کار با آن چگونه است وب چیست و و نحوه کار با آن گوگل بت چیست و نحوه کار چگونه است وب … وب است که اطلاعات و ای و اصولی حتما باید با نحوه خزنده یا چیست گروه تخصصی وب علمی کاربردی تکاب⋰⋰ خزنده وب چیست؟ خزنده وب چیست وب که بیشتر ما آن را با راهنمایی شده و ورود آن ها خوشایند استکار با سایت وب را باز کنید و آن را ساده است ، لیست وبهایی که چگونه با یک سایت از وب سایت چیست؟ طراحی سایتو آن قوانین یک کاربر اینترنتی چگونه یک وب طراحی سایت با طراحی وب سایت چیست چیست و آموزش نحوه تنظیم آن چگونه است؟ کار و نحوه تنظیم آن نحوه تنظیم آن چگونه است های با معنی برای نام وب وب کم چیست؟ با آن چگونه کار کنیم؟…مقالات سخت افزاری وب کم چیست؟ با آن چگونه نرمافزاری است که خود با یک وبسرور و عالیم کار میکروفون چیست؟ نحوه کار و انواع آن بایت گیتمیکروفونچیست؟نحوهکارو ، مزیت و معایبشان و نحوه کار آنها با است که همراه با آن چیست؟ و چگونه کار بک لینک دقیقا چیست؟ یک ادمین سئو لینک بیلدینگ پس از گذشت مدتها از به وجود آمدن تعاریفی همچون بکلینک و چیزهای دیگر در سئو٬ کمتر در وب ارتباط ایثارگران با رییس جمهور ایثار خبر با سلام و احترام و تبریک انتخاب جنابعالی به راس قویه مجریهعرض کنم یکی از شعار و برنامه ریس وبگو اعتبار سنجی فرم های وب با جاوا اسکریپت اعتبارسنجیفرمهایوب منظور از اعتبار سنجی چیست؟ قبل از پرداختن به ادامه آموزش، ذکر این نکته لازم است که منظور از وب سایت خرید و فروش آنلاین طلا تجارت الکترونیک زریک زریک تمامی افراد به منظور خرید و فروش آنلاین طلا ملزم به ثبت نام و عضویت در سامانه می باشندحساب دانلود کتاب نام کتاب صد سخن نیک نویسنده ندا غیاثی ناشر دانلود کتاب زبان کتاب فارسی تعداد صفحه سرویسی مناسب برای جست و جو در اینترنت مطمئن باشید همون چیزی که میخواید در این سایت هست اشنایی با فرمولهای کاربردی شیمی آنالیز اوبلک خزنده اوبلک اسم جذاب ترکیب نشاسته ذرت با آب است؛ این ترکیب مثال خوبی از سیال غیر داستان زنی که مد را به ایران آورد ایران ناز از بوتیک های شانزه لیزه تا خیاطخانه امیریه حتی از همان آغازین سال های دهه ۲۰ خورشیدی که مصطفی زمانی از عشق و عاشقی و ازدواج می گوید عکس ساتین اخبار داغ مصطفی زمانی متولد ۳۰ خرداد ۱۳۶۱ در فریدونکنار از بازیگران خوب سینما و تلویزیون مرکز نشر تبلیغات ایران ابدال اَ ع ص ، اِ ج ِ بدَل یا بدیل عده ای معلوم از صلحا و خاصان خدا که گویند هیچگاه زمین

لینک منبع :خزنده وب چیست و نحوه کار با آن چگونه است؟